Griesgrämige Katzen, ulkig lachende Kinder, sentimentale Superhelden oder peinliche Tanz-Challenges: Memes finden sich in jeder Ecke des Internets und bringen in knappen Text-Bild-Kombinationen die Skurrilität des Alltags auf den Punkt – als Insiderwitze für die Masse.

Ob Olaf Scholz' Augenklappe, Bernie Sanders' Strickhandschuhe oder Leonardo DiCaprios Cocktailgläser: erfolgreiche Memes gehen einher mit Elementen, die für die meisten Nutzer keiner Erklärung bedürfen. Auch politische Botschaften werden auf diese Weise gestreut, unterlegt mit Bildern aus der Pop- oder Alltagskultur, die vielen vertraut sind.

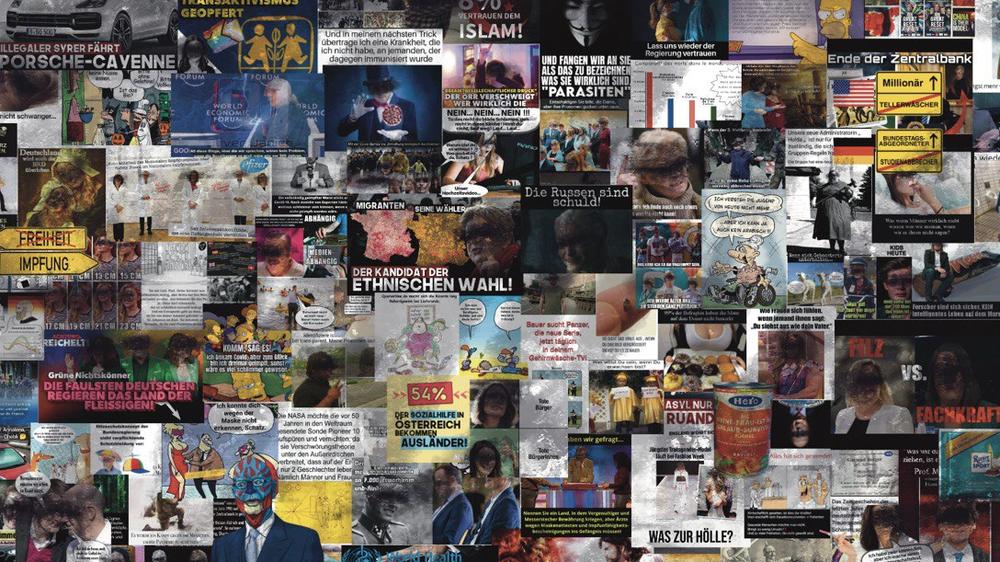

Doch nicht jedes Meme ist zum Totlachen. In die Flut grafischen Materials mischen sich diskriminierende Botschaften. Immerhin stellt die weitverbreitete Kulturtechnik des Memes einen Spiegel der Gesellschaft dar, in dem sich ihre Muster der gruppenbezogenen Abwertung zeigen. Dass solche vor allem in rechtsextremen oder auch verschwörungsideologischen Zusammenhängen vorkommen, liegt wohl auf der Hand.

Nur: Wer genau wird da in welchem Maße und in welcher Weise abgewertet? Zu diesem Zweck hat die Bundesarbeitsgemeinschaft Gegen Hass im Netz Memes aus knapp 1.700 Kanälen aus diesem Spektrum der Messenger-App Telegram untersucht. Dabei wurde mithilfe künstlicher Intelligenz eine Stichprobe aus 42.000 Bildern ausgewählt, von denen wiederum über 2.000 Memes als potenziell gruppenabwertend identifiziert wurden.

Wenn Memes Gewalt gegen Frauen verharmlosen

Wir sprechen von potenzieller Abwertung, weil viele Memes als abwertend gelesen werden können, aber nicht müssen. Für den jeweiligen Betrachter mögen sie eindeutig sein, für die verschiedenen Nutzer bieten sie aber große Interpretationsspielräume – den jeweiligen Vorannahmen und Vorurteilen entsprechend.

Umso mehr gilt das, wenn komplexe politische Zusammenhänge das Thema sind. Und noch mehr, wenn eine ironische Dimension enthalten ist. Was nämlich als Kritik an politischen Einstellungen und was als gruppenbezogene Abwertung gelten kann, ist umstritten. Mitunter in potenziell betroffenen Gruppen selbst.

Als Maßstab für die Identifizierung diskriminierender Memes galt uns, ob sie insbesondere von Angehörigen bestimmter Gruppen als solche gelesen werden können. Fünf Abwertungskategorien schälten sich dabei heraus: Frauenfeindlichkeit, Homo- und Transfeindlichkeit, Antisemitismus, Rassismus und Muslimfeindlichkeit.

Die meisten diskriminierenden Memes betreffen Frauen. Über 31 Prozent der untersuchten Bilder können als misogyn gelesen werden. Allerdings ist bei einem Großteil Frauenfeindlichkeit nur subtil ausgeprägt: Es wird Spaß mit Stereotypen gemacht. Offener Frauenhass liegt selten vor. Dafür aber finden sich Memes, in denen Gewalt gegen Frauen verharmlost oder Frauen die sexuelle Selbstständigkeit abgesprochen wird. So etwa, wenn eine am Boden liegende lädierte Frau als zu schade zum Wegschmeißen beschrieben wird; sie sehe doch noch gut aus.

Kruder Alltagshumor für die Massen

Weiterhin dominant sind Memes, die sich als Abwertung wegen Transgeschlechlichkeit und – in geringem Maße – sexueller Orientierung lesen lassen. Gerade bei Transfeindlichkeit ist die Interpretation aber stark abhängig von der Perspektive. Wenn sich in einem Meme ein Fuchs zum Huhn erklärt, um damit Zugang zum Stall zu erlangen, mag das manchen als Angriff auf die Existenz von trans Personen gelten, anderen als Kritik an identitätspolitischen Forderungen nach geschlechtlicher Selbstbestimmung und ihrer Missbrauchsmöglichkeiten durch Männer.

In neun Prozent der Bilder sind gleich mehrere Gruppen von den Schmähungen betroffen. Eine besonders enge Beziehung zeigt sich zwischen Rassismus und Muslimfeindlichkeit sowie Frauen- und Transfeindlichkeit.

Abwertung ist aber nicht gleich Feindlichkeit. Sie kann subtil in Form von Stereotypen daherkommen oder latent in Form von Vorurteilen. Manifest ist sie dort, wo man einer Gruppe offen feindlich gegenüber eingestellt ist. Die Zuordnung zu einer Abwertungskategorie meint daher nicht unbedingt, dass bei einem Meme Hass im engeren Sinne vorliegt; es umfasst auch Fälle, in denen seine Vorstufen zum Ausdruck kommen.

Telegram eilt der Ruf voraus, ein Hotspot extremistischer Propaganda zu sein. Entsprechend könnte man auch politisch derbes Material in der dortigen Meme-Produktion erwarten. Allerdings haben wir es bei dem untersuchten Material mehr mit einem chauvinistischen Alltagshumor für die Massen zu tun als mit einer speziellen Hasskultur. Die Abwertungsmuster sind wohlbekannt, unerfreulich, aber auch kaum gewaltaffin und relativ moderat.

Wie sich Bildbotschaften künftig entwickeln

Dennoch lässt sich ein spezieller Geschmack der Nutzer daran ablesen, wie oft Memes geteilt werden: So sind frauenfeindliche Memes zwar häufig, sie werden aber rund 30 Prozent seltener weitergeleitet als der Durchschnitt. Antisemitische Memes hingegen erfuhren anderthalbmal so viel Resonanz. Bildlich angesprochen werden dabei etwa jüdische Allmachtsfantasien, oft in Bezug auf Verschwörungstheorien wie den Great Reset.

Gleichwohl würde solch eine Analyse auf einer anderen Plattform vermutlich anders ausfallen. Telegram als textspezifisches Medium belohnt Bilder nicht so sehr wie Plattformen mit Newsfeeds, die von einem Algorithmus gesteuert werden.

Die Zukunft wartet mit einer zunehmenden Automatisierung von Bildbotschaften auf. Hierbei beobachten wir bereits jetzt diverse Accounts, die Propaganda mit Material verbreiten, das von künstlicher Intelligenz erstellt wurde. Ob dadurch Gruppenabwertungen zunehmen, sei aber dahingestellt. Denn die KIs sind häufig darauf trainiert, Diskriminierung zu vermeiden. Ein wahrscheinliches Szenario: Bei KI-generierten Grafiken dürften künftig weniger einzelne Gruppen das Feindbild sein – sondern vielmehr die politische Ordnung an sich.

Maik Fielitz und Holger Marcks sind Sozialwissenschaftler und leiten gemeinsam die Forschungsstelle der Bundesarbeitsgemeinschaft Gegen Hass im Netz. Eine ausführliche Analyse zur Nutzung von Memes in demokratiefeindlichen Räumen haben sie gemeinsam mit Lisa Bogerts, Wyn Brodersen, Christian Donner, Pablo Jost, Harald Sick und Hendrik Bitzmann in der aktuellen Ausgabe des wissenschaftlichen Onlinemagazins "Machine Against the Rage" veröffentlicht.

Griesgrämige Katzen, ulkig lachende Kinder, sentimentale Superhelden oder peinliche Tanz-Challenges: Memes finden sich in jeder Ecke des Internets und bringen in knappen Text-Bild-Kombinationen die Skurrilität des Alltags auf den Punkt – als Insiderwitze für die Masse.

Ob Olaf Scholz' Augenklappe, Bernie Sanders' Strickhandschuhe oder Leonardo DiCaprios Cocktailgläser: erfolgreiche Memes gehen einher mit Elementen, die für die meisten Nutzer keiner Erklärung bedürfen. Auch politische Botschaften werden auf diese Weise gestreut, unterlegt mit Bildern aus der Pop- oder Alltagskultur, die vielen vertraut sind.